初心者でもわかる!LoRA × Stable Diffusion XL徹底解説 大規模画像生成を軽量&高品質にカスタマイズする方法

以下の記事は、LoRA(Low-Rank Adaptation)とStable Diffusion XL(SDXL)の組み合わせに関するリサーチ内容を、初心者にも分かりやすいように丁寧に専門用語を解説しながら、漏れなくまとめたものです。記事後半には実際の活用事例や学習方法、最先端の研究動向なども詳しく紹介しています。「大規模な画像生成AIをもっと身近にカスタマイズしたい」という方は、ぜひ最後までご覧ください。

また、弊社では「AI使いたいが、どのような適用領域があるのかわからない…」「AI導入の際どのサービス提供者や開発企業を組めばいいかわからない…」という事業者の皆様に、マッキンゼーやBCGで生成AIプロジェクトを経験したエキスパートが完全無料で相談に乗っております。

興味のある方はぜひ以下のリンクをご覧ください:

代表への無料相談はこちら

AI導入.comを提供する株式会社FirstShift 代表取締役。トロント大学コンピューターサイエンス学科卒業。株式会社ANIFTYを創業後、世界初のブロックチェーンサービスを開発し、東証プライム上場企業に売却。その後、マッキンゼー・アンド・カンパニーにコンサルタントとして入社。マッキンゼー日本オフィス初の生成AIプロジェクトに従事後、株式会社FirstShiftを創業。

1. LoRAがSDXLに適用される方法

● LoRA(Low-Rank Adaptation)の概要とSDXLへの適用

LoRA(Low-Rank Adaptation)とは?

- 「大規模モデルを効率的にカスタマイズする技術」です。

- 本来は大規模言語モデル(例:ChatGPTなど)向けに開発されましたが、画像生成モデルに応用する動きが活発化。

- モデルの重み(パラメータ)を「低ランク行列」に分解し、ごく少数の追加パラメータだけを学習する仕組みになっています。

ここでいう「低ランク行列」というのは、元の大きな行列を“薄く圧縮して”管理するようなイメージです。その結果、元のモデルを大幅に変更することなく、小さな差分だけを学習できるわけです。

Loraに関する詳しい解説記事はこちら

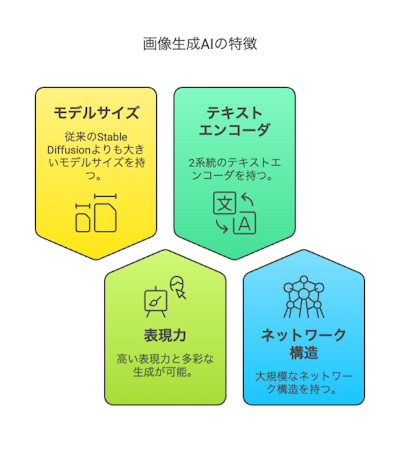

Stable Diffusion XL(SDXL)とは?

- テキスト(文章)を入力すると、AIがそれをもとに画像を生成してくれる「画像生成AI」モデルのひとつ。

- 従来のStable Diffusionよりもモデルサイズが大きく、高い表現力・多彩な生成が可能。

- テキストエンコーダが2系統あり、大規模なネットワーク構造を持っているため、ベースモデル自体は数GB~10GB以上の容量になることも。

● LoRAとSDXLの構造

SDXLにLoRAを挿入する仕組み

- Stable Diffusionには「U-Net」という、画像変換の重要な部分を担うネットワークがあります。

- さらにU-Netには「クロスアテンション層」という、テキスト情報(文章)と画像情報を関連付ける計算部分が存在。

- LoRAは、このクロスアテンション層(Q, K, Vなどの行列)に“差し込み”して、そこだけ微調整するケースが一般的です。

- クロスアテンション(Cross Attention)とは?

- 簡単に言うと、文章の情報と画像中のピクセルの対応関係を学習する仕組み。たとえば「猫」という単語に対してどの部分の画像を“猫らしく”描くかを決める重要な部分です。

- クロスアテンション(Cross Attention)とは?

学習後、LoRAとして追加されたパラメータ(数MB~数十MB程度)を保存しておき、推論(画像生成)の際にベースモデルへ上乗せ(合成)することで、「LoRAで覚えた新しいスタイルやキャラクター」を反映した画像生成が可能になります。

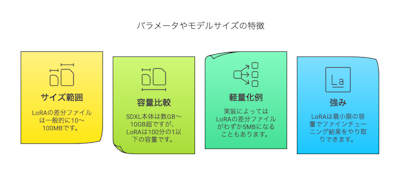

● パラメータやモデルサイズの特徴

- LoRAが生む差分ファイルは、一般的に10~100MB程度。

- SDXL本体が数GB~10GB超のサイズであることを考えると、100分の1以下の容量で済むことも珍しくありません。

- 実装によってはさらに軽量化され、わずか5MBの例も報告されています。

- このように最小限の容量でファインチューニング結果をやり取りできるのが、LoRAの強みです。

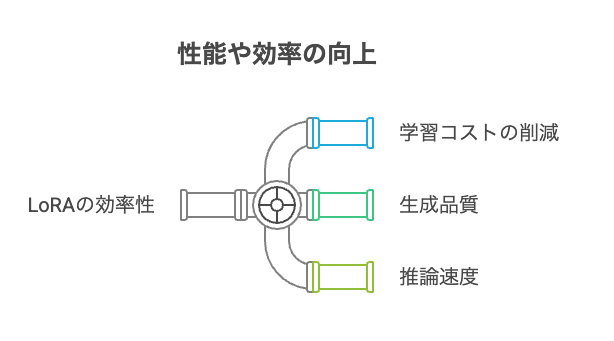

2. 性能や効率の向上

LoRAを用いてSDXLをカスタマイズすると、どのようなメリットがあるのでしょうか? 以下に主なポイントをまとめます。

● 学習コストの削減

- LoRAは学習対象パラメータ数を大幅に減らすため、学習時間やGPUメモリ消費量を抑えられます。

- フルモデル再学習のように数十億のパラメータを更新しなくても、1%未満の部分的な学習だけで済む場合もあります。

- その結果、より少ないハードウェア(GPUメモリ)や学習時間で、SDXLを好みのスタイルに仕立て上げられます。

● 生成品質への影響

- 「部分的な学習のみ」で本当に高品質を維持できるの?という疑問がありますが、実際のレポートでは、

- フルモデル微調整と大きな差がない画質が得られている事例が多数。

- 5~10枚程度の少量画像からでも、新しいキャラクターや人物、オリジナルの画風を十分に再現できる例が報告されています。

- DreamBooth手法(特定の人物や対象物をAIに覚えさせる仕組み)との併用では、たった5枚程度の写真から個人の肖像をかなり忠実に生成できます。

● 推論速度の変化

- LoRAを適用しても、推論(画像生成)の速度はほとんど変わりません。

- 追加計算としては“低ランク行列の積(かけ算)”が少し増えるだけなので、フルモデルと比べて誤差レベルの差にとどまります。

- 多様なスタイルを用意したい場合でも、ベースモデルを一度ロードしておけばLoRAファイルを差し替えるだけで済むため、運用の効率も向上します。

3. 実際の事例やユースケース

LoRA+SDXLは、研究機関から企業応用、オープンソースのコミュニティに至るまで様々な場面で取り入れられています。

● 研究機関での活用例

- 画像復元・修復分野

- 2024年の研究では、2600枚の画像を使ってSDXLをLoRAで微調整したところ、高解像度画像の欠損を補完する精度が大幅に向上。

- 生成だけでなく、欠損部分を自然に埋めるなど、幅広い画像処理タスクに有効であることが示されました。

● 企業での採用例

- AWS(Amazon Web Services)

- Amazon SageMaker上でStable Diffusion XLをDreamBooth+LoRAで効率よく微調整する公式ブログが公開。

- 低コストかつクラウド活用で、安全に企業向けモデルを運用できるメリットが注目されています。

- Space‐O Technologies社

- SDXLをLoRAで「個人写真」に特化したモデルを作成。

- 個人に合わせた画像生成サービスを展開する上で、フルモデルを置き換えずに小さな差分だけでパーソナライズを実現している事例です。

● オープンソースコミュニティ・アーティスト事例

- Hugging Face🧨Diffusers:LoRAによるStable Diffusion微調整が公式サポートされており、誰でもSDXLにLoRAを適用・共有しやすい環境が整っています。

- Civitai:ユーザーが作成したLoRAモジュールを手軽に公開・ダウンロードできるサイト。

- 例:「Peppa Pig - SDXL LoRA」など、アニメや有名キャラのLoRAもコミュニティで盛り上がりを見せています。

- アーティスト・クリエイター:自身の画風をLoRAとして学習させ、SDXL上で自由に新作を生み出すクリエイティブな実験が活発です。

4. トレーニングやファインチューニングの方法

● LoRA+SDXLの学習手法

- データセットの用意

- 学習させたいスタイルや人物の写真、イラストなどを少数(5~30枚程度)用意。

- キャプション(テキスト説明)を付与しておくと精度向上が期待できます。

- クロスアテンション層などにLoRAを適用

- 一般的にはU-Netのクロスアテンション(Q, K, V行列)を対象に追加モジュールを挿入。

- 必要に応じてテキストエンコーダ側にもLoRAを導入し、新単語やキャラクター名などを覚えさせることも可能です。

- 実際の学習フロー

- Hugging FaceのDiffusersや、コミュニティ製の“Kohya SSスクリプト”を用いると比較的簡単に学習可能。

- RTX4090クラスのGPUがあれば、30枚のデータで2~4時間ほどでLoRAを作成できたという報告もあります。

- ただしVRAM(GPUメモリ)節約のため、バッチサイズを小さくする・Gradient Checkpointingを使うなどの工夫が必須です。

- DreamBooth方式との併用

- 少量画像で過学習を防ぐ“正則化画像”を交えた学習手法。

- たとえば人物写真に限定したい場合、正則化画像として一般の顔画像を混ぜ、モデルの多様性が失われないよう工夫します。

● ハードウェア要件や設定のポイント

- SDXLは大型モデルなので、12GB~24GBクラスのGPUが推奨されます。

- しかし、FP16(半精度)やBF16、解像度の制限、サンプル生成のオフなどを徹底すれば8GB前後のGPUでも学習可能という報告があります。

- rank(秩)の設定:

- 秩を高くするとパラメータが増え、より表現力が増す反面ファイルサイズや過学習リスクもアップ。

- SD1.5ではrank 64が一般的でしたが、SDXLではrank 16~32くらいでも十分な結果が得られるケースが多いようです。

● LoRAを適用した後の使い方

- 学習後に得られる差分ファイル(LoRAモジュール)を数十MB程度で保存。

- 推論時には、Automatic1111などのWeb UIでベースのSDXLモデルをロードし、そこにLoRAファイルを追加適用するだけ。

- 新たなCheckpointを作る必要はなく、必要に応じてLoRAをオン・オフできる柔軟さが魅力です。

- 複数LoRAを合体(マージ)して、一つのモデルに焼き付ける方法もあります。

詳しいLoRAの作り方はこちら

5. 最新の研究動向や今後の展望

● 推論高速化とLoRA

- LoRAは本来、学習の効率化を目的とした技術ですが、最近は推論(画像生成の時間短縮)にも活用されつつあります。

- Latent Consistency Models(LCM)と呼ばれる拡散プロセスのステップをスキップする技術と組み合わせた「LCM-LoRA」によって、数秒かかっていた生成を1秒以下に短縮する試みが報告されています。

● ゼロショットLoRA生成

- 従来はLoRAを作る際、少なくても数分~数時間の学習が必要でした。

- 2024年末に発表された「LoRA Diffusion」の論文によると、学習せずにLoRAを直接生成する(ゼロショット)手法が探究されています。

- 「○○風の絵柄」とテキストで指定するだけで、理想のLoRAを合成することを目指す研究。

- まだ研究段階ですが、将来的にはデータ収集不要・学習不要でLoRAを瞬時に作り出す未来が来るかもしれません。

● 他手法との併用と標準化の流れ

- ControlNetなどの追加制御モジュールとも組み合わせやすく、カスタマイズの自由度がさらに高まっています。

- 研究段階では、「拡散モデルの注意機構にLoRAを初めから組み込み、性能を底上げする」試みも出てきています。

- LoRAが“画像生成モデルの拡張モジュール”として、事実上の標準カスタマイズ手法になりつつある状況です。

6. まとめ

LoRA×Stable Diffusion XL(SDXL)の組み合わせには、次のような大きな意義があります。

- 軽量かつ効率的に大規模モデルをカスタマイズ

- SDXLのような数GB~10GB超の巨大モデルを、わずか数MB~数十MBの差分だけで調整

- 学習コストやGPUメモリ負荷の削減に直結

- 高い生成品質を保持

- 部分的な微調整にもかかわらず、フルモデル再学習と遜色ないレベルの画質を得られる

- 少数画像(5枚~30枚)から新しいキャラクターや人物を忠実に再現

- 運用負荷を抑えて多様なスタイルを試せる

- 推論時の速度低下はほぼ皆無

- ベースモデル+LoRAファイルを切り替えるだけで、別のアートスタイルやキャラを簡単に適用

- 今後も広がる研究と応用範囲

- 推論高速化やゼロショットLoRA生成など、新たなアプローチが続々と登場

- 企業やコミュニティでの実績が増え、標準ツールとして定着しつつある

これからLoRA×SDXLを始める方へ

- 少ないGPUリソースでも挑戦しやすい

- 8GB~12GBのGPUメモリがあれば、FP16・解像度調整などの工夫で学習可能。

- ビジネスから個人の創作まで対応

- 企業では製品やブランド独自のスタイル構築に、個人のアーティストやクリエイターは画風の自動生成に活用。

- オープンソースコミュニティをフル活用

- Hugging FaceやCivitaiなどで多くの事例やチュートリアルが公開されているので、まずは既存のLoRAを試してみるのがおすすめです。

LoRAはStable Diffusion XLのカスタマイズを劇的に容易にする技術として、今後ますます重要視されるはずです。大規模画像生成AIに興味がある方や、独自のスタイルモデルを作りたい方は、ぜひ本記事を参考にチャレンジしてみてください。きっと新しいクリエイティブ体験やビジネスチャンスにつながることでしょう。

AIサービス導入のご相談は AI導入.com へ(完全無料)

- マッキンゼー出身の代表による専門的なアドバイス

- 日本・アメリカの最先端AIサービスの知見を活用

- ビジネスの競争力を高める実践的な導入支援